El generador de imágenes se puso en marcha en febrero de 2024 como parte de la aplicación Gemini. Irónicamente, no produjo muchas de las imágenes obviamente racistas o sexistas que los críticos temían. En cambio, tuvo el problema contrario. Cuando un usuario pedía a Gemini que creara “una imagen de un senador estadounidense del siglo XIX”, le aparecían imágenes de mujeres negras, hombres asiáticos o una mujer nativa americana con un tocado de plumas, pero ni un solo hombre blanco. También había imágenes más perturbadoras, como la representación que hacía Gemini de grupos de soldados alemanes de la época nazi como personas de color. Los republicanos del Congreso se burlaron de la “IA woke” de Google. Elon Musk publicó repetidamente en X sobre los fallos de Gemini, calificando a la IA de “racista y sexista” y señalando a un miembro del equipo de Gemini como responsable. El empleado cerró sus cuentas en las redes sociales y temió por su seguridad, según sus compañeros. Google detuvo la capacidad del modelo para generar imágenes de personas, y las acciones de Alphabet volvieron a caer.

Las publicaciones de Musk desencadenaron charlas entre decenas de dirigentes de Google. Vicepresidentes y directores volaron a Londres para reunirse con Hassabis. Al final, tanto el equipo de Hassabis (Gemini, el modelo) como el de Hsiao (Gemini, la aplicación) recibieron permiso para contratar a expertos que evitaran percances similares, y se añadieron 15 puestos de confianza y seguridad.

De vuelta en Gradient Canopy, Hsiao se aseguró de que el equipo responsable del generador de imágenes tuviera tiempo suficiente para corregir el problema. Con la ayuda de Manyika, otros miembros del personal desarrollaron un conjunto de principios públicos para Gemini, todos ellos redactados en torno a “ti”, el usuario. Gemini debe “seguir tus indicaciones”, “adaptarse a tus necesidades” y “salvaguardar tu experiencia”. Uno de los puntos importantes era subrayar que “las respuestas no reflejan necesariamente las creencias u opiniones de Google”, según los principios. “Los resultados de Gemini se basan en gran medida en lo que le pides que haga: Gemini es lo que tú haces que sea”. Esto era una buena tapadera para futuros errores. Pero no quedaba claro qué prácticas podría introducir Google para rendir cuentas de esos principios.

De texto a podcast

Sobre las seis y media de una tarde de marzo de 2024, dos empleados de Google se presentaron en la mesa de Josh Woodward, en la zona amarilla de Gradient Canopy. Woodward dirige Google Labs, una unidad de lanzamiento rápido encargada de convertir la investigación en productos totalmente nuevos, y los empleados estaban ansiosos por que escuchara lo que habían creado. Utilizando transcripciones de comparecencias en el Parlamento británico y el modelo Gemini con un largo contexto, habían generado un podcast llamado Westminster Watch con dos presentadores de IA, Kath y Simon. El episodio empezaba con Simon hablando con un alegre acento británico: “Ha sido otra semana animada en la Cámara, con mucho drama, debate e incluso una pizca de historia”. Woodward estaba fascinado. Después, dice, fue contándoselo a todo el mundo, incluido Pichai.

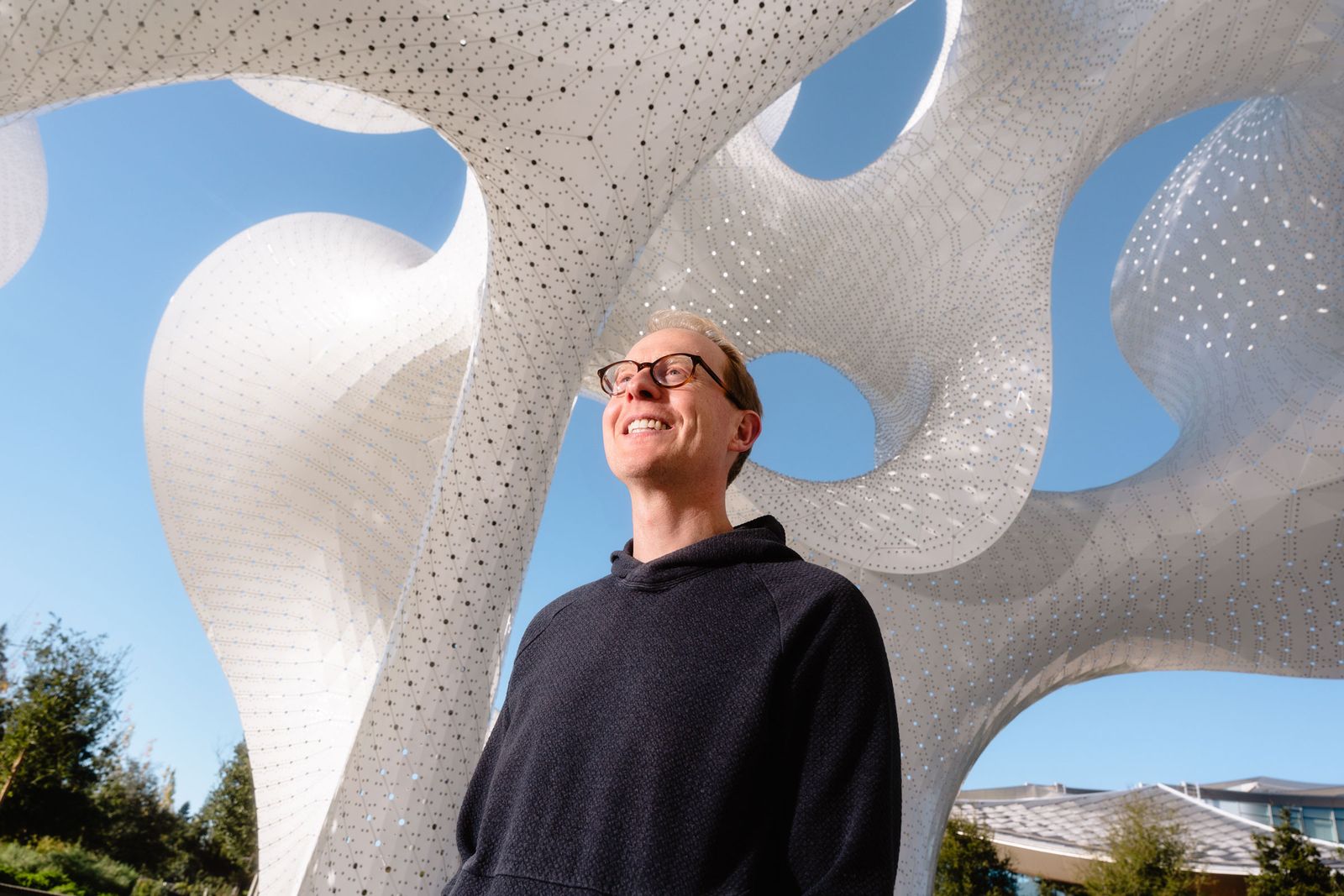

Josh Woodward en el Monumento Orb, afuera de Gradient Canopy.Foto: Scott Hutchinson

La herramienta de conversión de texto a podcast, conocida como NotebookLM Audio Overviews, se incluyó en el programa de la conferencia Google I/O de mayo. Un equipo básico trabajó sin descanso, noches y fines de semana, para tenerla lista, según explicó Woodward a WIRED. “En este punto, han escuchado literalmente miles y miles” de podcasts generados por inteligencia artificial. Pero cuando llegó el evento mediático de los 35 millones de dólares, otros dos anuncios acapararon la mayor parte de la atención. Uno era un prototipo de Astra, un asistente digital capaz de analizar video en directo (el mundo real, en tiempo real) que Brin mostró entusiasmado a los periodistas. El otro era la esperada mejora de la IA generativa para las búsquedas.

El equipo del Proyecto Magi había diseñado una función llamada AI Overviews, que podía sintetizar los resultados de una búsqueda y mostrar un resumen en un recuadro en la parte superior de la página. Desde el principio, el personal responsable de la innovación había advertido de los problemas de parcialidad y precisión y de las implicaciones éticas para los sitios web que podrían perder tráfico de búsqueda. Querían cierta supervisión a medida que avanzaba el proyecto, pero el equipo se había reestructurado y dividido.

¿Comer al menos una roca al día?

A medida que la IA se desplegaba, la gente recibía algunos resultados extraños. Al buscar “¿cuántas rocas debo comer?” aparecía la respuesta “Según los geólogos de la UC Berkeley, se recomienda comer al menos una roca pequeña al día”. En otra consulta viral, un usuario buscó “el queso no se pega a la pizza” y obtuvo este útil consejo: “añade aproximadamente 1/8 de taza de pegamento no tóxico a la salsa para darle más pegajosidad”. Las meteduras de pata tenían explicaciones sencillas. El pegamento para pizzas, por ejemplo, se originó a partir de un post gracioso de Reddit. Pero los resúmenes de IA presentaban la información como un hecho. Google redujo temporalmente la presentación de los resúmenes para recalibrarlos.

Según Pandu Nayak, jefe científico de Google encargado de las búsquedas y veterano de 20 años en la empresa, que no se detectaran todos los problemas antes del lanzamiento fue una lástima, pero no una sorpresa. En general, los resúmenes de IA funcionaron muy bien. Simplemente, los usuarios no solían fijarse en el éxito. “Lo único que hacen es quejarse”, afirma Nayak. “Con lo que estamos comprometidos es con la mejora constante, porque garantizar que no vas a tener problemas no es una posibilidad”.